Киберпреступники активно эксплуатируют технологии подделки голоса для хищения средств у своих жертв. Об этом сообщил руководитель Центра цифровой экспертизы Роскачества Сергей Кузьменко.

По его словам, мошенники используют нейросети на основе искусственного интеллекта для создания убедительных голосовых копий знакомых или родственников потенциальных жертв. Для этого им нужен лишь небольшой фрагмент записи голоса, который они могут получить из аудио- и видеоматериалов в социальных сетях, мессенджерах или даже во время телефонного разговора.

Когда человек слышит знакомый тембр в трубке, он теряет бдительность и без колебаний переводит деньги на счета незнакомцев. Кузьменко подчеркивает, что обман раскрывается, как правило, уже после совершения транзакций.

Преступные схемы постоянно совершенствуются. Сейчас появляется всё больше видеозвонков с применением технологии дипфейк. «Это не просто голос, а живое изображение близкого человека с его мимикой и движениями. Мощный эффект присутствия разрушает последние барьеры осторожности, заставляя мозг поверить в реальность происходящего», — пояснил эксперт.

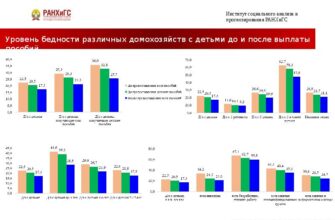

Ранее также сообщалось о значительном росте числа детей, пострадавших от мошенничества в России. По данным МВД, за первые девять месяцев 2025 года этот показатель увеличился на 120 процентов.